Google tiene claro cómo va a entrenar sus modelos de IA. Cogiendo todo lo que publiquemos en internet

Uno suele saber a lo que atenerse cuando usa servicios de Google. Es el Gran Hermano definitivo, y sabemos que la recolección de datos es una constante al usar cualquiera de sus plataformas. Es un sacrificio que aceptamos implícitamente al usar herramientas como Gmail, YouTube o Google Maps, pero las cosas pueden ir aún más allá. De hecho, lo acaban de hacer.

Nuevos términos de privacidad. Como indican en Gizmodo, Google actualizó hace unos días su política de privacidad. Lo hicieron con un cambio importante que hace mención específica a cómo entrenan sus modelos de inteligencia artificial. En el documento oficial explican lo siguiente:

«Google puede recoger información públicamente disponible online, o a partir de otras fuentes públicas, para ayudar a entrenar modelos de IA de Google y desarrollar productos y funciones como el Traductor de Google, Bard y funciones de IA de Cloud».

Si es contenido público, lo usarán (potencialmente). Es importante destacar que Google habla de información públicamente disponible online. La empresa parece por tanto reservarse el derecho de recopilar y potencialmente aprovechar contenidos de toda la web, y hacerlo precisamente por el hecho de que ese contenido es público.

Cuidado con lo que publicas. Eso hace que una vez más no sea mala idea reflexionar sobre todo lo que publicamos o subimos en internet sin más. A menos que marquemos esos contenidos como privados o protegidos por derechos de autor, Google los podrá usar para cosas como entrenar sus modelos de inteligencia artificial. Lo dicen bien en Gizmodo: lo importante ya no es tanto quién puede ver esa información que publicamos, sino cómo va a acabar usándola (porque podrá acabar haciéndolo).

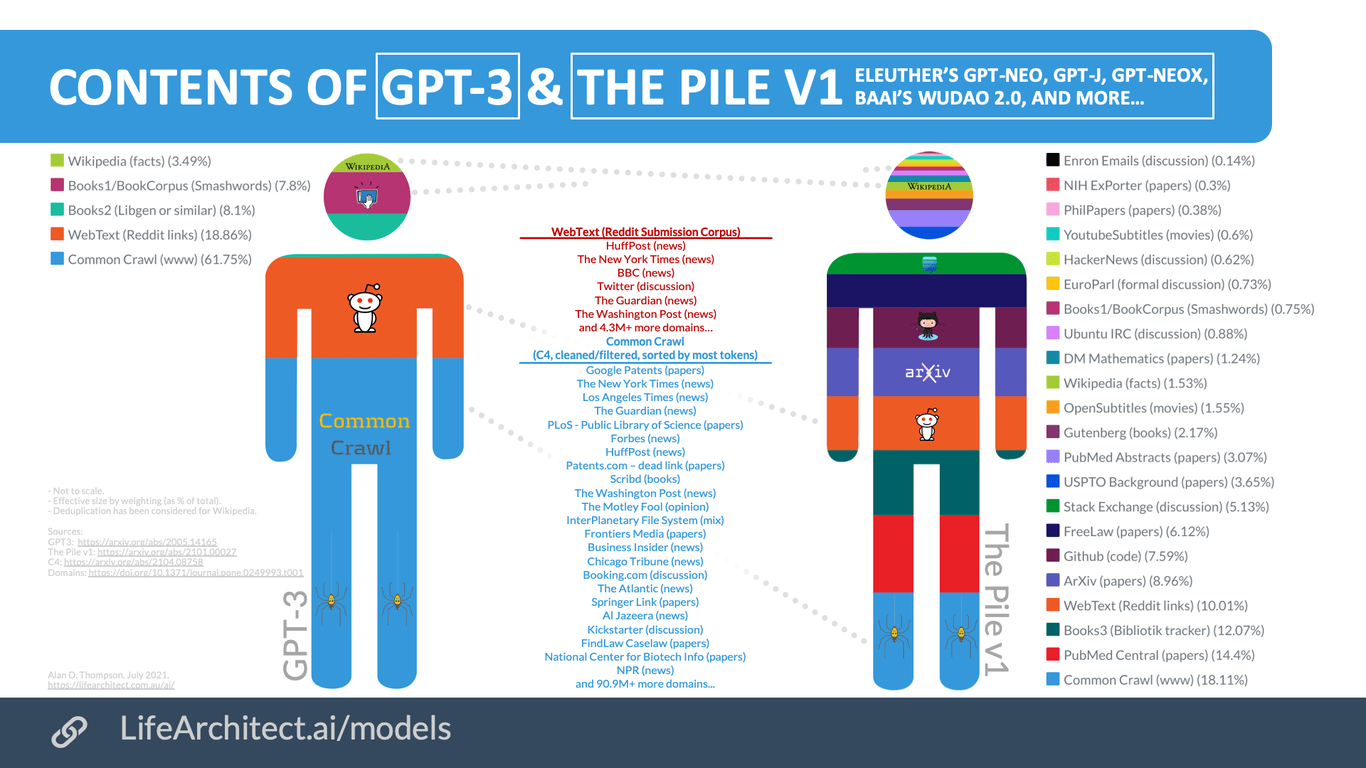

Transparencia casi nula. Y mientras esto pasa, las empresas que ofrecen modelos de IA generativa siguen sin ofrecer datos claros sobre cómo entrenan sus plataformas. Google es una de las pocas que expone esos «datasets» utilizados en algunos modelos: el llamado Google C4 es un gigantesco conjunto de datos que permiten descubrir que las fuentes más relevantes son Google Patents, Wikipedia y Scribd.

Sin embargo no hay apenas datos sobre Infiniset, el conjunto de datos usados para el modelo de lenguaje LaMDA utilizado en Bard. De PaLM2 no sabemos mucho, y tampoco está demasiado claro cómo entrenó OpenAI el modelo GPT-3 —hay un estudio de sus ingenieros que no aclara demasiado la cuestión— y la opacidad se ha convertido en una máxima últimamente: las empresas desvelan cada vez menos detalles porque la competencia es feroz.

Pero todas usan internet sin piedad. Lo que sí está claro es que los contenidos publicados en internet en todo tipo de plataformas —blogs, redes sociales, foros, etc— acaba siendo potencialmente usada para entrenar esos modelos de datos. Lo que no sabemos en la mayoría de los casos es si eso que nosotros publicamos estará o no, y sin saber las fuentes concretas, tampoco es posible entender hasta qué punto los ChatGPT o Bard del mundo pueden tener ciertos sesgos en un sentido u otro.

Por eso Reddit y Twitter están tomando medidas. Lo que acaba de hacer Google al cambiar su política de privacidad tiene mucho que ver con la decisión de Reddit y Twitter de limitar el acceso a sus APIs: si no se paga, no se podrá acceder a ellas. O lo que es lo mismo: si no se paga, usar las enormes cantidades de contenido publicado en esas redes es mucho más difícil para empresas que quieren entrenar sus modelos de IA con esos datos.

Internautas sin voz ni voto. Y mientras, los internautas que publicamos esos contenidos no parecemos poder hacer nada al respecto. Cuando publicamos algo en internet, sea donde sea, normalmente lo hacemos de forma automática y sin pensar en si ese contenido debería estar sujeto a alguna licencia. Mi blog, por ejemplo, usa una licencia Creative Commons que requiere atribución. Aunque el dataset Google C4 ha recopilado algunos de mis posts para su entrenamiento, a mí jamás se me ha pedido permiso (en realidad no tendrían que hacerlo obligatoriamente) ni se me ha citado o atribuido (que sí deberían hacer según esa licencia).

¿Demandas a la vista? Google, como todas las demás, están aprovechando internet como su particular campo de entrenamiento para trabajar en el campo de la inteligencia artificial, pero eso podría acabar costándole caro. OpenAI y Microsoft están ahora en medio de una demanda por GitHub Copilot y todo el código que esa herramienta ha usado sin pedir permiso a los programadores.

A Stable Diffusion le pasa algo similar con Getty, cansada de que la IA le robe sus fotos. El propio David Holz, fundador de Midjourney, admitía que al entrenar su modelo «No hay realmente una forma de coger cien millones de imágenes y saber de dónde provienen. Estaría bien que las imágenes tuvieran metadatos incrustados sobre el propietario del copyright o algo así. Pero eso no existe; no hay ningún registro».

La AI Act persigue este tipo de problemas. Mientras tanto en la Unión Europea progresa la aprobación definitiva de la AI Act, su primer intento de regular la inteligencia artificial. En esta normativa hay un apartado específico dedicado a la transparencia, y teóricamente se exigirá a las empresas que desarrollan modelos de IA que expliquen de dónde provienen los datos de entrenamiento.

Eso es mucho más fácil de hacer que de dedir aparentemente, pero nos enfrentamos a un futuro en el que este tipo de recopilación masiva de datos puede tener problemas adicionales: ya no solo de posible violación de privacidad, sino de su uso en según qué escenarios. En Xataka nos hemos puesto en contacto con los responsables de Google, y actualizaremos la noticia si recibimos más información sobre estos cambios en su política de privacidad.

Nota original aquí

Fuente: Xataka/Javier Pastor